南科大计算机系6篇论文被 ICCV 2023录用

近日,南科大计算机系6篇论文被计算机视觉国际顶会ICCV 2023(International Conference on Computer Vision)(CCF A类会议)录用。我系张建国教授和郑锋副教授为指导老师和通讯作者。ICCV是国际计算机视觉大会,由IEEE主办,是计算机视觉方向的三大顶级会议之一,代表了计算机视觉领域最新的发展方向和水平。

1 Transferable Decoding with Visual Entities for Zero-Shot Image Captioning

Junjie Fei, Teng Wang, Jinrui Zhang, Zhenyu He, Chengjie Wang, Feng Zheng*

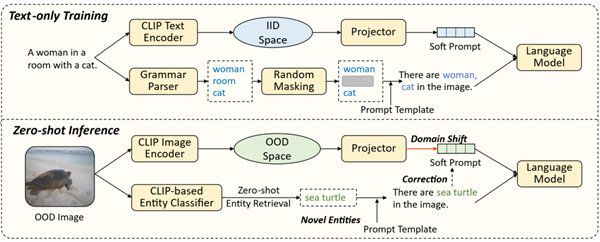

微调预训练的视觉-语言模型(VLM)和大语言模型(LLM)来完成图像到文本的生成近期受到了广泛关注,但目前主流的方法在描述具有新分布的图像时,生成的文本质量往往不佳。我们观察并通过实验验证了其潜在原因:1)模态偏置,当来自于图像的指导弱时,LLM通过预训练获得的语言先验占据文本生成的主导地位。2)物体混淆,在少量下游样本上微调预训练大模型极易导致过拟合,即模型常常会将图像中不认识的物体识别并描述为训练时见过,但在图像中实际不存在的物体。基于以上观察,我们提出一种新的微调方法,即ViECap,它结合两种不同的提示词来完成可迁移的图像到文本生成任务:1)通过映射网络来从视觉特征中学习一个关注图像整体信息的软提示词。2)通过冻结的CLIP来从开放词库中检索图像中存在的物体以构建硬提示词,使模型对于超出微调数据集分布的图像更具鲁棒性。实验验证ViECap能够有效的迁移到多个图像到文本的生成场景。当迁移到未知分布的图像时,我们的模型在文本生成质量上大幅超越现存的其他同类型的工作。

南科大智能与感知课题组科研助理费俊杰和2020级博士生王腾为论文共同第一作者,郑锋老师为通讯作者,南方科技大学为第一单位。

2 Set-level Guidance Attack: Boosting Adversarial Transferability of Vision-Language Pre-training Models

Dong Lu, Zhiqiang Wang, Teng Wang, Weili Guan, Hongchang Gao, Feng Zheng*

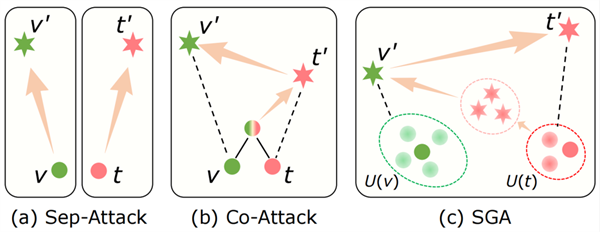

现有的视觉语言预训练(VLP)模型在多模态任务中对对抗样本显示出了脆弱性。此外,恶意生成的对抗样本还可以用于迁移攻击其他的黑盒模型。然而,现有的研究主要集中在研究白盒攻击。在本文中,我们首次研究了现有的VLP模型的对抗迁移性。结果显示,与白盒设置中的强攻击性能相比,现有的方法的迁移能力较弱。

我们发现,这种迁移性的降低主要源于多模态交互的不充分利用:(1)不同于传统的单模态学习,VLP模型高度依赖于多模态数据间的交互,(2)多模态数据具有内在的对齐性和互补性,图像与文本之间的多对多对齐关系提供了多样性引导,即同一图像可用多种自然语言描述。然而,现有方法未充分考虑多模态间的交互,无法建立跨模态对应关系,或仅使用单一的图像-文本对,限制了跨模态引导的多样性。

为了提高攻击方法的对抗迁移性,我们提出了一种集合级引导攻击(Set-level Guidance Attack, SGA)方法。SGA充分利用了多模态数据间的交互,同时结合了保留对齐的数据增强和跨模态引导。实验结果显示,SGA能在多个下游视觉-语言任务上生成对抗样本,这些样本能高效迁移至不同的VLP模型。

南科大计算机系2021级博士生陆东和2020级硕士生王志强为论文共同第一作者,郑锋老师为通讯作者,南科大为第一单位。

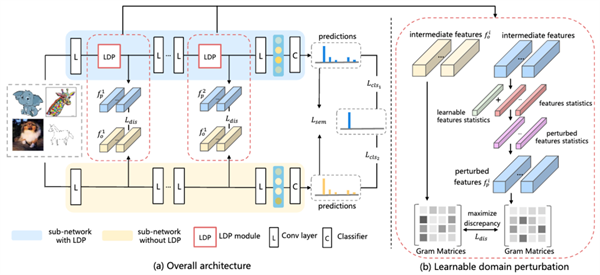

3 Cross contrasting Feature Perturbation for Domain Generalization

Chenming Li,Daoan Zhang,Wenjian Huang,Jianguo Zhang*

域泛化(Domain Generalization)问题旨在从训练集所属的域中学习一个鲁棒的模型,从而可以很好地泛化到未见过的目标域上。近来该领域较为热门的研究方向是通过生成不同于源域的样本或特征,使模型能从更多样化的域分布中学校到泛化性更好的表征能力。然而,这些方法很难解决生成特征或样本的语义失真问题。在本文中,我们提出了一种在线单阶段交叉对比特征扰动(CCFP)框架,通过在隐空间中生成扰动特征来模拟域偏移现象,同时约束模型在面对域偏移现象时的预测结果一致。与之前的隐空间特征合成策略不同,我们设计了具有可学习的特征扰动和语义一致性约束的模块。与之前的工作相比,我们的方法不需要使用任何生成式模型或域标签。我们在标准DomainBed基准测试上进行了大量实验,并采用严格的评估方法进行公平比较。大量的综合实验表明,我们的方法优于之前的SOTA。实验分析表明我们的方法可以缓解分布外(Out-of-Distribution)场景中的域偏移问题。

南科大计算机系2021级硕士生李晨鸣为论文第一作者,张建国老师是通讯作者,南科大为第一单位。

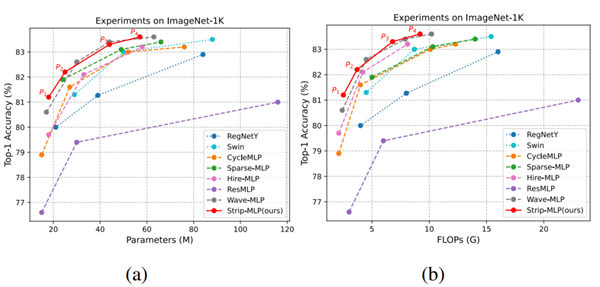

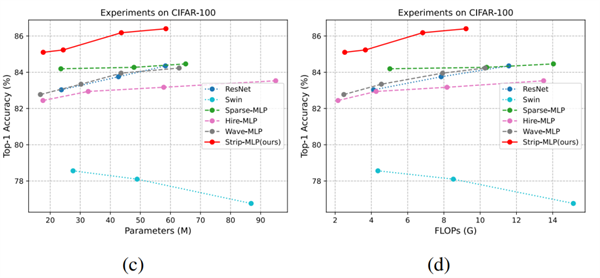

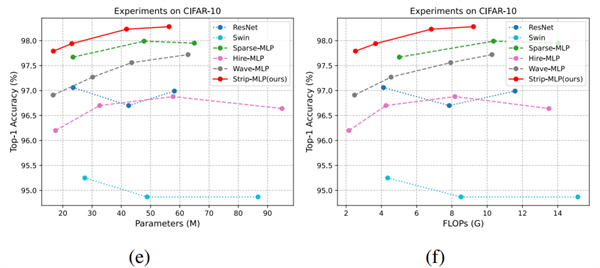

4 Strip-MLP: Efficient Token Interaction for Vision MLP

Guiping Cao, Shengda Luo, Wenjian Huang, Xiangyuan Lan*, Dongmei Jiang, Yaowei Wang, Jianguo Zhang*

近年来,继卷积神经网络(CNN-based)模型和Transformer-based模型之后,MLP-based模型已逐渐成为计算机视觉领域又一主流深度学习模型。Token交互是MLP-based模型的核心模块之一,主要用于对不同空间位置的token进行信息交互和信息聚合。然而,MLP-based模型存在显著的token交互困境(Token’s Interaction Dilemma),即token在空间维度上的信息交互能力会随特征空间分辨率的下降而下降,尤其在模型的深层特征中,特征图将下采样至更小的尺寸,严重降低了模型的表达能力。

针对以上问题,我们提出了一种名为Stirp-MLP的新模型,以提升token的交互效率和能力。我们创新提出了一种新型MLP范式:Strip MLP layer,该网络层允许每行(或每列)的token对相邻行(或列)的token产生特异性的贡献,从而提升token交互能力。基于该网络层,我们分别提出了一个级联分组带状混合模块(CGSMM)和局部带状混合模块(LSMM),用于解决因特征分辨率减小而引起的模型性能降低问题,以及提升模型的局部区域信息聚合能力。实验结果表明,Strip-MLP具有更高的模型精度和效率,在小数据集显著优于已有MLP-based、CNN-based、Transformer-based模型。在基准大数据集中,具有与其他SOTA模型相当的精度,同时在模型参数量和计算复杂度具有显著的优势,可作为基础视觉模型应用于下游任务中,应用前景广泛。

2021级南方科技大学-鹏城实验室联培博士生曹桂平为论文第一作者,我系张建国老师和鹏城实验室蓝湘源老师为通讯作者,南科大为第一作者单位。

5 Knowledge-Aware Prompt Tuning for Generalizable Vision-Language Models

Baoshuo Kan, Teng Wang, Wenpeng Lu*, Xiantong Zhen, Weili Guan and Feng Zheng*

预训练的视觉-语言模型(例如CLIP)结合手动设计的提示,在迁移学习方面展示出强大的能力。最近,可学习的提示实现了最先进的性能,但往往容易过拟合于已见类别,难以泛化到未见类别。针对这个问题,本文提出了一种面向视觉-语言模型的知识感知的提示方法(KAPT)。KAPT 为文本编码器设计了两种互补类型的知识感知提示,以利用与类别相关的外部知识的独特特征。离散提示从物体类别的描述中提取关键信息,而学习得到的连续提示则捕捉整体上下文。KAPT还为视觉编码器设计了一个适应头,以聚合显著的注意力视觉线索,从而建立具有区分性和任务感知的视觉表示。在11个广泛使用的基准数据集上进行了大量实验,结果验证了KAPT在小样本图像分类方面的有效性,特别是在泛化到未见类别方面。

南科大智能与感知课题组访问学生阚保硕和2020级博士生王腾为共同第一作者,郑锋老师与鹿文鹏老师为通讯作者,齐鲁工业大学为第一单位。

6 Learning Cross-Modal Affinity for Referring Video Object Segmentation Targeting Limited Samples

Guanghui Li, Mingqi Gao, Heng Liu*,

Xiantong Zhen, Feng Zheng*

指代式视频目标分割(RVOS)是在自然语言的引导下,实现对视频中感兴趣目标的分割与跟踪的任务。由于用户友好的交互方式,其在视频编辑相关领域中具有广泛应用。近年来,主流的RVOS方法实现了出色的性能,但由于依赖充分的视觉-语言数据标注,难以在少量样本的场景下获得理想的结果,因而限制了其在现实任务中的应用。在本文中,我们提出了一种简单有效的模型(Cross-Modal Affinity,CMA)提升对少样本RVOS的准确性。通过在少量样本中建立跨模态的特征关联,CMA能够快速学习新的视觉语言对应以适应不同的任务场景。为了推进样本有限RVOS领域的研究,我们在已有视频目标分割数据集的基础上,建立了少样本RVOS基准数据集,Mini-Ref-YouTube-VOS和Mini-Ref-SAIL-VOS,在场景,语言,特征空间等方面涵盖多样的数据样本。我们的实验表明,相比于已有的少样本学习方案,提出的CMA能够更精准的学习样本中的视觉语言对应,实现对不同场景的快速适应。

南科大视觉智能与感知课题组访问研究生李光辉和我系2019级博士生高明琦为共同第一作者,郑锋老师与刘恒老师为通讯作者,安徽工业大学为第一单位。