我系学生在CVPR 2024 PVUW 运动表达引导视频分割挑战赛中夺冠

在近日举办的IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) 2024 Workshop上,南方科技大学计算机科学与工程系的学生在Pixel-level Video Understanding in the Wild (PVUW)运动表达引导视频分割比赛中荣获第一名。这一成就不仅展示了我系学生在实际视频场景中的出色解决方案能力,也反映了我系在视频理解领域的深厚研究基础和持续的创新精神。

图1. 挑战赛奖状

赛事介绍

Pixel-level Video Understanding in the Wild (PVUW)是CVPR 2024 Workshop下一个旨在推进图像分割任务向视频分割任务过渡的系列挑战赛。赛事主办方针对实际应用中更为复杂的动态视频场景,提供了一系列新的数据集和赛道,以推动图像分割任务向视频分割任务的发展。今年的PVUW挑战包括四个赛道,其中“运动表达引导视频分割”(Motion Expression guided Video Segmentation)赛道聚焦于根据描述对象动作的句子来分割视频内容中的对象,从而适应复杂环境下的视频理解需求。

赛事回顾

随着视频内容的复杂性日益增加,传统的视频分割技术常常难以准确识别和跟踪视频中的动态对象。特别是在长视频和复杂场景中,如何根据自然语言的描述来精确分割特定对象,一直是计算机视觉领域的一大挑战。此前的研究多聚焦于短视频或静态属性较多的视频,未能充分利用视频的时间信息,因此无法充分理解视频中的动态信息。

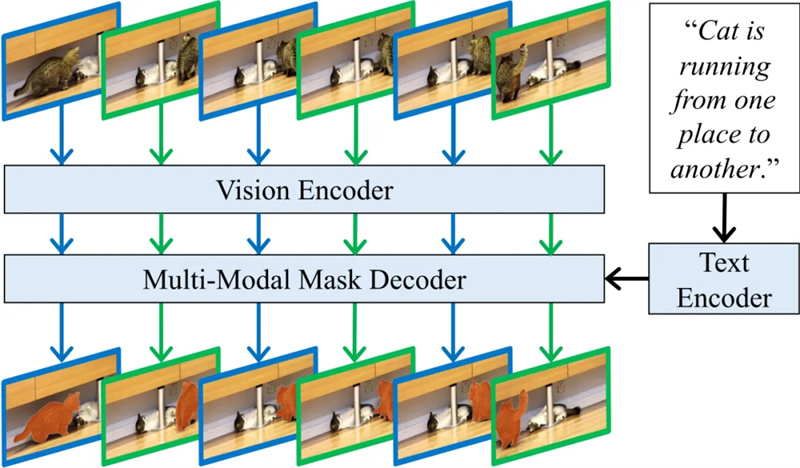

为了应对该挑战,赛事主办方特别设计了MeViS数据集,用于研究动态场景中的视频分割任务。与以往的数据集相比,MeViS引入了新的挑战,如以动作为主导的语言表达、多个同类实例的复杂场景、一对多的文本与对象对应关系及长视频处理。参赛队伍的任务是根据给定的自然语言描述,在视频中精确识别并分割出该描述所指代的目标对象。这要求队伍不仅要理解语言中的动作描述,还要将这些描述准确地映射到视频中动态变化的视觉内容上。在本次赛事中,针对动态场景和长时间视频的难点,参赛队伍首先使用了基于transformer的时序建模技术来精确对齐视频目标与文本描述。接着,在静态数据上训练模型的基础分割能力,并利用动态场景视频数据强化模型对动作的敏感性,以实现模型对不同场景的适应能力。最后,对长视频进行帧采样并将其分割为子视频,以优化长期视频理解的效率。这些策略的综合应用使模型有效提升了动态目标的分割质量,并在该任务的通用评价指标上取得了0.5447的高分分数,排名第一。

图2. 方法整体框架图

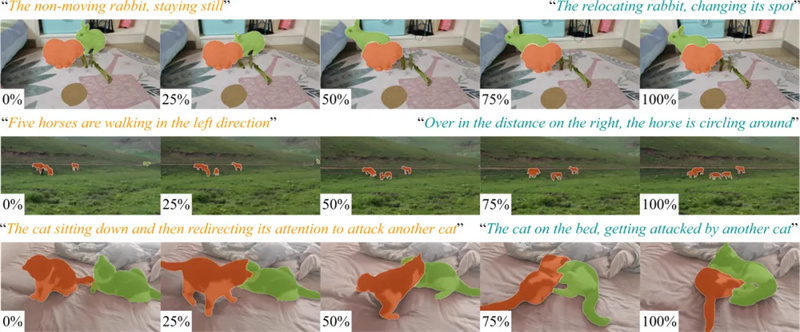

图3. 挑战数据可视化结果

郑锋老师、罗景南和高明琦(从左至右)

该工作由塔普智能(Tapall.ai),南方科技大学,谢菲尔德大学,华威大学共同合作完成。该工作的共同第一作者为南科大计算机系2019级博士研究生高明琦和南科大计算机系2023级硕士研究生罗景南,通讯作者为我系郑锋副教授。